![]()

Batch Normalization (배치 정규화) - 신경망을 훈련할 때 일반적으로 어려운 한 가지는 가중치를 일정한 범위 내에서 유지해야 한다는 것입니다. 가중치가 커지기 시작하면 gradient exploding 문제가 발생하고 작아지면 gradient vanishing 문제가 발생합니다. - 신경망의 입력 데이터 스케일을 조정하는 이유 중 하나는 처음 시작되는 훈련을 안정적으로 시작하기 위함입니다. 처음 네트워크의 가중치가 랜덤 하게 초기화되어 학습되기 때문에 스케일 조정이 되지 않으면 큰 폭으로 출렁이게 됩니다. 그래서 앞서 CNN을 구현했을 때 입력 데이터의 0 ~ 255 사이의 픽셀 값 대신 0 ~ 1 사이의 스케일로 바꿨습니다. - 입력 데이터의 스케일을 조정했기 때문에 모든 layer의 ..

![]()

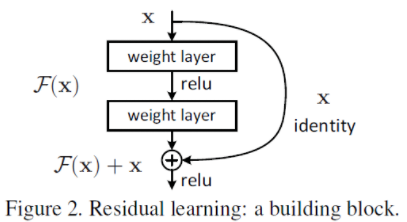

GOAL - ResNet의 구조를 이해 - Tensorflow를 이용하여 ResNet50으로 CIFAR10 데이터셋을 이용하여 분류해 보자 Residual Network - 오늘은 2015년 ILSVRC에서 우승을 차지한 Residual Network(이하 ResNet)에 대해 포스팅하려고 합니다. - ResNet은 마이크로소프트에서 개발한 알고리즘으로 원 논문명은 "Deep Residual Learning for Image Recognition"입니다. 어마어마한 논문의 인용 수를 볼 수 있으며 이는 딥러닝 이미지 분야에서 많이 사용되고 있다는 뜻입니다. - CNN이 이미지 인식 분야에서 뛰어난 성능을 보여주고 있었고, 네트워크의 layer를 깊이 쌓으며 성능 향상을 이루고 있었습니다. 하지만 실제로 ..

![]()

GOAL - VGGNet의 구조를 이해 - Tensorflow를 이용하여 VGG16으로 CIFAR10 데이터셋을 이용하여 분류해 보자 VGGNet - VGGNet은 2014년 ILSVRC에서 2위를 한 Oxford 대학교의 VGGNet 팀에서 만든 모델입니다. - 구조적인 측면에서 굉장히 간단한데 성능은 훌륭하며 변형을 시켜가면서 테스트하기에 좋아 많이 사용되고 있습니다. - AlexNet과 무엇이 다른지 확인하고 VGGNet16을 구현해 보도록 하겠습니다. 네트워크의 깊이(depth) - 앞서 설명한 AlexNet의 Layer의 수는 8개였습니다. 그에 비해 VGGNet16은 Layers수가 16개로 더 깊어진 것을 볼 수 있습니다. - 망이 깊어지면 출력단에서 하나의 픽셀이 담고 있는 정보의 양이 많..

![]()

GOAL - Alexnet의 구조를 이해 - Tensorflow를 이용하여 AlexNet으로 CIFAR10 데이터셋을 이용하여 분류해보자 AlexNet - AlexNet은 2012년 ImageNet 데이터를 기반으로 한 ILSVRC(ImageNet Large Scale Visual Recognition Challenge) 대회에서 캐나다의 토론토 대학이 차지하는데 당시 논문의 첫 번째 저자가 Alex Khrizevsky이며 이 분의 이름을 따서 AlexNet이라고 부르게 되었다. - SuperVision이 AlexNet을 의미하며 다른 팀들과 차이가 많이 나는 것을 볼 수 있다. - 이 대회 이후 ILSVRC에는 딥러닝을 이용한 모델들이 주를 이뤘으며 더 좋은 성능을 보이게 된다. - 구조적 관점을 보았..